cara setting robot.txt utk di crawl google adsense

Table of Content

Mengoptimalkan Crawling Google Adsense dengan Robot.txt: Panduan Lengkap

Robot.txt, file sederhana namun sangat penting, berperan krusial dalam mengontrol bagaimana mesin pencari, termasuk Googlebot (crawler Google), mengakses dan mengindeks situs web Anda. Penggunaan robot.txt yang tepat, khususnya dalam konteks Google Adsense, dapat memastikan bahwa Googlebot mengakses konten yang relevan untuk penayangan iklan, sekaligus mencegah akses ke area yang tidak diinginkan, seperti halaman internal atau file yang sensitif. Artikel ini akan membahas secara detail cara setting robot.txt untuk optimasi crawling Google Adsense, mencakup pemahaman dasar, praktik terbaik, dan contoh penerapannya.

Memahami Dasar-Dasar Robot.txt

Robot.txt adalah file teks sederhana yang ditempatkan di root directory website Anda (misalnya, www.example.com/robots.txt). File ini berisi instruksi untuk user-agent (bot atau crawler) mesin pencari, menentukan halaman mana yang boleh diakses dan mana yang harus dihindari. Dengan kata lain, ini adalah mekanisme untuk mengontrol akses bot ke website Anda, bukan untuk memblokir pengguna manusia. Pengguna masih dapat mengakses halaman yang diblokir oleh robot.txt melalui URL langsung.

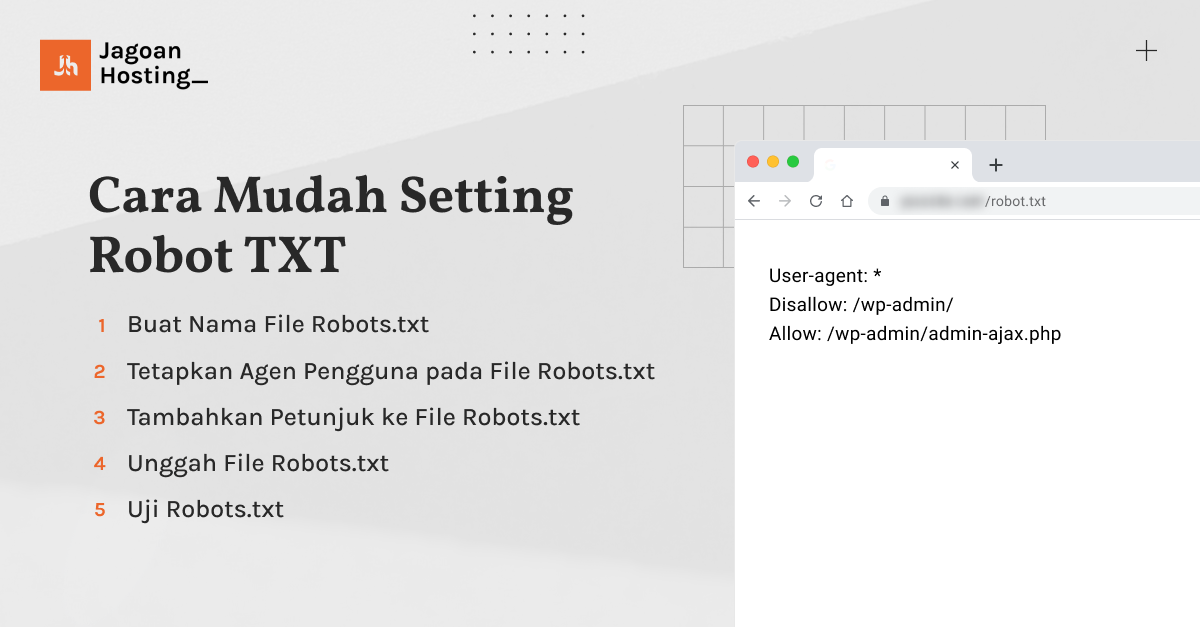

Struktur Dasar Robot.txt

File robot.txt memiliki struktur yang sederhana dan mudah dipahami. Ia terdiri dari dua directive utama:

-

User-agent:: Menentukan bot atau crawler mana yang akan dikenai instruksi.*menandakan semua user-agent.

Disallow:: Menentukan path atau URL yang tidak boleh diakses oleh user-agent yang telah ditentukan.

Contoh sederhana:

User-agent: * Disallow: /admin/

Disallow: /private/

Disallow: /admin/

Disallow: /private/Kode di atas menginstruksikan semua bot (*) untuk tidak mengakses direktori /admin/ dan /private/.

Optimasi Robot.txt untuk Google Adsense

Integrasi Google Adsense membutuhkan crawling yang efektif oleh Googlebot untuk memastikan iklan ditampilkan di halaman yang relevan dan sesuai kebijakan Adsense. Oleh karena itu, setting robot.txt yang tepat sangat penting. Berikut beberapa poin penting:

-

Jangan memblokir halaman utama atau halaman penting lainnya: Pastikan halaman utama (

/), halaman kategori utama, dan halaman konten utama lainnya tidak diblokir. Googlebot perlu mengakses halaman-halaman ini untuk memahami struktur situs dan relevansi konten Anda dengan iklan yang akan ditampilkan. -

Blokir halaman yang tidak relevan atau sensitif: Halaman seperti halaman login, area administrasi, halaman draft, file konfigurasi, atau halaman yang berisi konten yang melanggar kebijakan Adsense harus diblokir. Ini mencegah Googlebot mengakses konten yang tidak diinginkan dan memastikan keamanan situs Anda.

-

Blokir file yang tidak perlu diindeks: File seperti file log, file cache, atau file backup biasanya tidak perlu diindeks oleh mesin pencari. Memblokir akses ke file-file ini dapat meningkatkan efisiensi crawling dan mengurangi beban server.

-

Gunakan

Allow:directive (opsional): SelainDisallow, Anda juga dapat menggunakanAllow:untuk menentukan path yang boleh diakses setelah path yang dilarang. Ini berguna untuk memberikan pengecualian pada aturanDisallow.

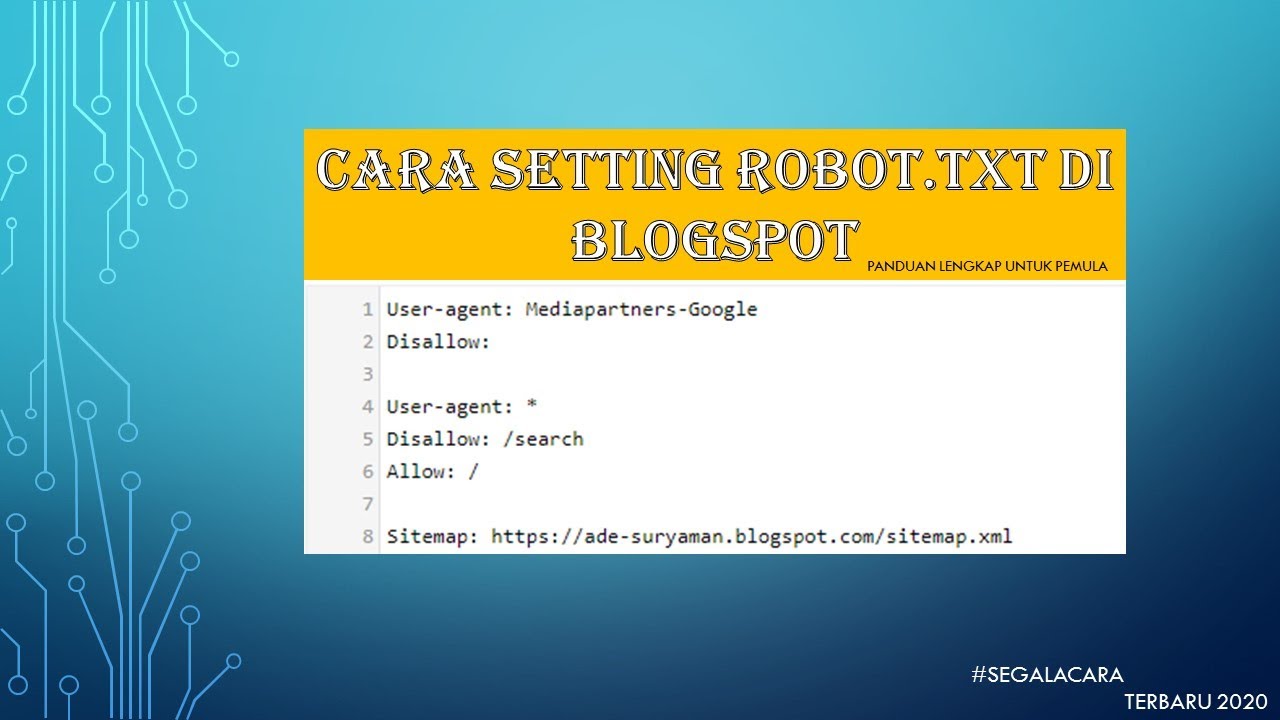

Contoh robot.txt yang lebih kompleks:

User-agent: *

Disallow: /admin/

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /cgi-bin/

Disallow: /?

Allow: /?utm_source=

Allow: /?ref=

Disallow: /private/

Disallow: *.pdf

Disallow: *.doc

Disallow: *.xls

User-agent: Googlebot-Image

Disallow: /images/thumbnails/Contoh di atas memblokir beberapa direktori umum, file dengan ekstensi tertentu, dan thumbnail gambar. Namun, ia memberikan pengecualian untuk URL yang mengandung parameter UTM dan REF, yang sering digunakan dalam kampanye pemasaran.

Praktik Terbaik dalam Setting Robot.txt

-

Lakukan pengujian: Setelah melakukan perubahan pada robot.txt, gunakan alat pengujian robot.txt (tersedia banyak secara online) untuk memastikan bahwa instruksi Anda diinterpretasikan dengan benar.

-

Perbarui secara berkala: Saat situs web Anda berkembang dan struktur direktori berubah, pastikan untuk memperbarui robot.txt Anda agar tetap akurat dan efektif.

-

Pertimbangkan penggunaan Sitemap: Sitemap XML memberikan informasi kepada Googlebot tentang struktur situs Anda dan halaman-halaman penting. Ini melengkapi robot.txt dan membantu Googlebot menemukan konten yang relevan dengan lebih efisien.

-

Jangan berlebihan: Memblokir terlalu banyak halaman dapat menghambat crawling dan berdampak negatif pada peringkat pencarian Anda. Hanya blokir halaman yang benar-benar perlu diblokir.

-

Prioritaskan keamanan: Pastikan untuk memblokir akses ke informasi sensitif dan area administrasi situs Anda.

Menguji dan Memantau Robot.txt

Setelah mengkonfigurasi robot.txt, penting untuk memverifikasi bahwa ia berfungsi dengan benar. Anda dapat menggunakan beberapa metode:

-

Google Search Console: Google Search Console menyediakan alat untuk memeriksa kesalahan robot.txt dan melihat bagaimana Googlebot mengakses situs Anda.

-

Alat pengujian robot.txt online: Banyak alat online yang tersedia untuk memvalidasi sintaks robot.txt dan melihat halaman mana yang diblokir atau diizinkan.

-

Menjalankan Googlebot secara manual (untuk pengguna berpengalaman): Meskipun tidak direkomendasikan untuk pengguna pemula, Anda dapat menggunakan metode ini untuk mengamati bagaimana Googlebot merayapi situs Anda setelah perubahan robot.txt.

Kesimpulan

Robot.txt adalah alat yang ampuh untuk mengontrol akses mesin pencari ke situs web Anda. Penggunaan yang tepat, terutama dalam konteks Google Adsense, dapat memastikan bahwa Googlebot mengakses konten yang relevan untuk penayangan iklan, sekaligus melindungi informasi sensitif. Dengan memahami dasar-dasar robot.txt, mengikuti praktik terbaik, dan secara teratur menguji dan memantau konfigurasi Anda, Anda dapat mengoptimalkan crawling Googlebot dan memaksimalkan potensi pendapatan Adsense Anda. Ingatlah untuk selalu mengutamakan keamanan dan relevansi konten saat mengkonfigurasi robot.txt. Jangan ragu untuk berkonsultasi dengan profesional jika Anda membutuhkan bantuan tambahan dalam mengelola robot.txt Anda. Penggunaan robot.txt yang efektif adalah investasi jangka panjang untuk kesehatan dan kinerja situs web Anda.