best robots.txt for adsense

Table of Content

Best Robots.txt untuk Adsense: Panduan Lengkap Optimasi dan Pencegahan Penyalahgunaan

Google Adsense, program periklanan kontekstual yang populer, menawarkan peluang monetisasi yang menarik bagi pemilik situs web. Namun, untuk memaksimalkan pendapatan dan menghindari pembatalan akun, penting untuk memahami dan mengoptimalkan file robots.txt Anda. File ini bertindak sebagai penjaga gerbang, memberi tahu mesin pencari (termasuk Googlebot, perayap Adsense) halaman mana yang boleh diakses dan mana yang harus dihindari. Artikel ini akan membahas secara mendalam tentang pembuatan robots.txt terbaik untuk Adsense, mencakup strategi optimasi, pencegahan penyalahgunaan, dan pemahaman mendalam tentang cara kerjanya.

Memahami Peran robots.txt dalam Adsense

File robots.txt bukanlah alat keamanan yang mencegah akses sepenuhnya ke situs Anda. Ia lebih berfungsi sebagai petunjuk sopan santun bagi crawler atau perayap mesin pencari. Meskipun Google umumnya mematuhi arahan dalam robots.txt, mereka tidak terikat secara hukum untuk melakukannya. Oleh karena itu, robots.txt tidak boleh digunakan untuk menyembunyikan konten yang melanggar kebijakan Adsense. Jika Google menemukan pelanggaran, mereka akan mendeteksi dan menindaklanjuti, terlepas dari apa yang tertulis dalam robots.txt.

Dalam konteks Adsense, robots.txt berperan penting dalam:

- Mengontrol akses Googlebot ke halaman tertentu: Anda dapat mencegah Googlebot mengakses halaman yang tidak relevan, berisi konten berkualitas rendah, atau yang mungkin menyebabkan masalah dengan Adsense. Misalnya, halaman yang sedang dalam pengembangan, halaman kesalahan 404, atau halaman yang berisi konten duplikat.

- Meningkatkan efisiensi perayapan: Dengan memblokir halaman yang tidak penting, Anda memungkinkan Googlebot untuk fokus pada halaman berkualitas tinggi yang lebih relevan dengan niche situs Anda, sehingga meningkatkan kemungkinan penayangan iklan yang lebih baik.

- Mencegah penyalahgunaan: Meskipun tidak mencegahnya sepenuhnya,

robots.txtdapat membantu mengurangi risiko penyalahgunaan, seperti scraping konten atau pencurian iklan. Dengan memblokir akses ke halaman sensitif, Anda mengurangi peluang terjadinya hal tersebut. - Mengoptimalkan pengalaman pengguna: Dengan mengarahkan Googlebot ke konten yang paling relevan, Anda membantu memastikan bahwa pengguna melihat konten yang paling relevan dan iklan yang paling sesuai, meningkatkan pengalaman pengguna secara keseluruhan.

Membangun robots.txt yang Optimal untuk Adsense

Berikut adalah langkah-langkah untuk membuat robots.txt yang efektif untuk Adsense:

-

Identifikasi Halaman yang Harus Diblokir: Mulailah dengan mengidentifikasi halaman-halaman yang tidak ingin Anda indeks oleh Google. Ini mungkin termasuk:

- Halaman yang sedang dalam pengembangan: Halaman yang belum selesai atau belum dioptimalkan dapat merusak reputasi situs Anda.

- Halaman kesalahan (404): Halaman 404 yang tidak terkelola dapat menunjukkan kualitas situs yang buruk.

- Halaman duplikat: Konten duplikat dapat menurunkan peringkat SEO Anda dan berdampak negatif pada Adsense.

- Halaman administrasi: Halaman login, dashboard, dan area administrasi lainnya tidak perlu diindeks.

- Halaman pencarian internal (jika tidak dioptimalkan): Hasil pencarian internal yang tidak terkelola dapat membingungkan Googlebot.

- Feed RSS atau XML: Meskipun beberapa feed mungkin bermanfaat, yang lain mungkin tidak perlu diindeks.

- Halaman dengan konten berkualitas rendah: Konten yang tipis, tidak relevan, atau plagiat dapat membahayakan situs Anda.

-

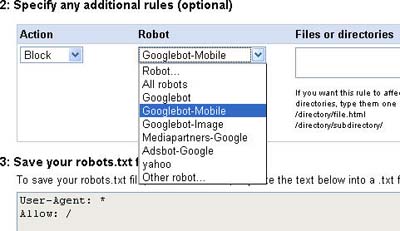

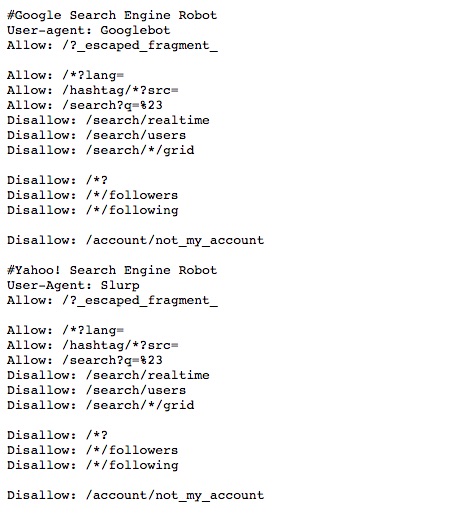

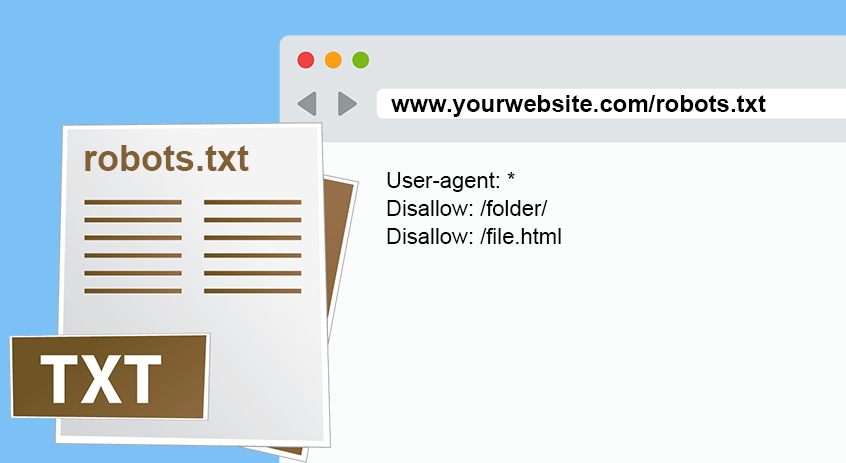

Buat Directive yang Tepat: Setelah mengidentifikasi halaman-halaman tersebut, Anda perlu membuat directive

robots.txtyang tepat. Sintaks dasarnya adalah:User-agent: <nama perayap>

Disallow: <path>Contoh:

User-agent: Googlebot

Disallow: /draft/

Disallow: /admin/

Disallow: /search-results/

User-agent: *

Disallow: /private/User-agent: *berarti instruksi berlaku untuk semua perayap./draft/berarti semua halaman di dalam direktoridraftakan diblokir. -

Uji robots.txt Anda: Setelah membuat

robots.txt, penting untuk mengujinya menggunakan alat pengujirobots.txtyang tersedia secara online. Ini akan membantu Anda memastikan bahwa filerobots.txtAnda berfungsi dengan benar dan tidak memblokir halaman yang seharusnya diakses. Google menyediakan alat pengujirobots.txtdi Search Console. -

Perbarui robots.txt Secara Berkala: Pastikan untuk memperbarui

robots.txtAnda secara berkala saat Anda menambahkan atau menghapus halaman di situs Anda. Kegagalan untuk melakukannya dapat menyebabkan masalah dengan perayapan dan pengindeksan Google.

Pencegahan Penyalahgunaan dan Pertimbangan Keamanan

Meskipun robots.txt bukan solusi keamanan yang komprehensif, ia dapat membantu mengurangi risiko penyalahgunaan. Berikut beberapa pertimbangan:

- Jangan mengandalkan robots.txt untuk melindungi informasi sensitif: Jangan pernah menggunakan

robots.txtuntuk menyembunyikan informasi sensitif seperti data pengguna, informasi keuangan, atau kunci API. Informasi ini harus dilindungi dengan mekanisme keamanan yang lebih kuat, seperti otentikasi dan otorisasi. - Gunakan

.htaccessuntuk keamanan tambahan: File.htaccessdapat memberikan lapisan keamanan tambahan, khususnya dalam hal membatasi akses ke direktori tertentu. - Pantau lalu lintas situs Anda: Pantau lalu lintas situs Anda secara teratur untuk mendeteksi aktivitas yang mencurigakan. Jika Anda melihat peningkatan yang tidak biasa dalam permintaan ke halaman yang seharusnya diblokir, ini mungkin mengindikasikan upaya penyalahgunaan.

- Perbarui perangkat lunak dan plugin secara teratur: Perbarui perangkat lunak dan plugin situs Anda secara teratur untuk memperbaiki kerentanan keamanan yang diketahui.

Kesimpulan

File robots.txt merupakan alat penting dalam mengoptimalkan situs Anda untuk Adsense. Dengan memahami cara kerjanya dan menerapkan strategi yang tepat, Anda dapat meningkatkan efisiensi perayapan, meningkatkan pengalaman pengguna, dan mengurangi risiko penyalahgunaan. Namun, ingatlah bahwa robots.txt bukanlah solusi keamanan yang sempurna. Kombinasikan penggunaan robots.txt dengan praktik keamanan yang kuat lainnya untuk melindungi situs dan pendapatan Adsense Anda. Selalu patuhi kebijakan Adsense untuk menghindari pembatalan akun. Terus pantau kinerja situs Anda dan sesuaikan robots.txt Anda sesuai kebutuhan untuk memastikan optimasi yang berkelanjutan. Dengan perencanaan yang matang dan pemeliharaan yang konsisten, Anda dapat memanfaatkan sepenuhnya potensi robots.txt untuk memaksimalkan pendapatan Adsense Anda.