cara setting robot.txt utk di crawl google adsense di wp

Table of Content

Mengoptimalkan Pengelolan Robot.txt untuk Google Adsense di WordPress: Panduan Lengkap

Robot.txt, file sederhana namun krusial, berperan sebagai penjaga gerbang bagi crawler mesin pencari seperti Googlebot. File ini menentukan halaman mana yang boleh diakses dan diindeks oleh crawler, dan mana yang harus dihindari. Penggunaan robot.txt yang tepat sangat penting, terutama jika Anda menggunakan Google Adsense di situs WordPress Anda. Pengaturan yang salah dapat mengakibatkan penurunan pendapatan Adsense, bahkan penalti dari Google. Artikel ini akan membahas secara detail cara mengatur robot.txt untuk situs WordPress Anda agar optimal untuk Google Adsense, termasuk strategi lanjutan dan pemecahan masalah umum.

Memahami Dasar-dasar Robot.txt

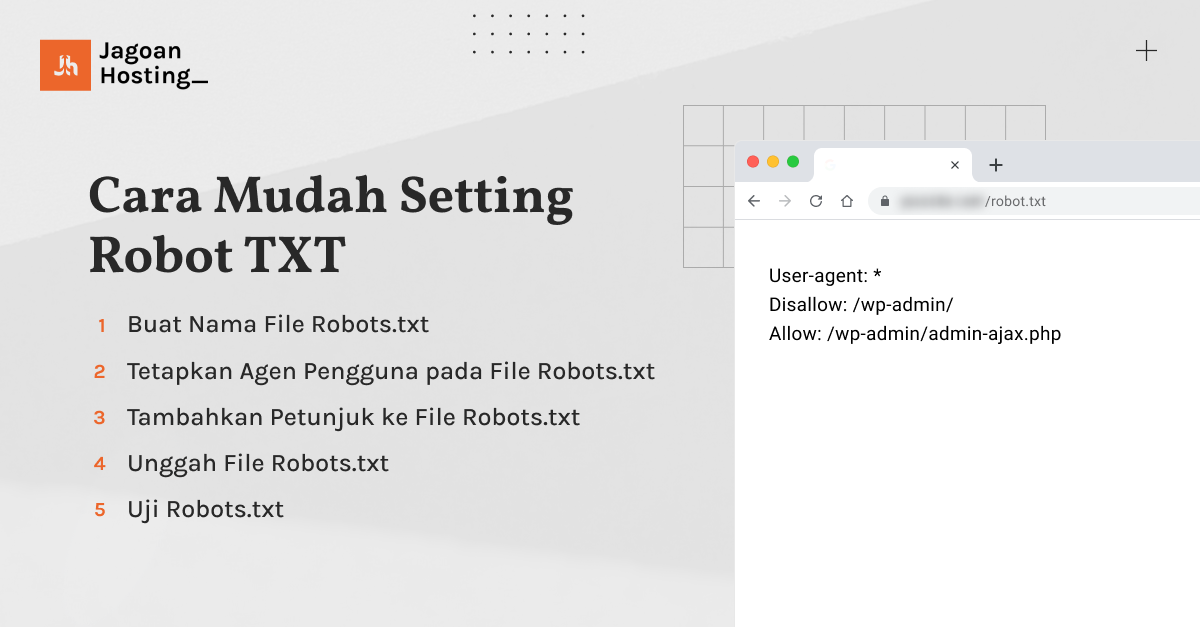

Robot.txt adalah file teks sederhana yang ditempatkan di root domain Anda (misalnya, www.example.com/robots.txt). File ini berisi instruksi untuk crawler mesin pencari, memberitahu mereka halaman mana yang boleh diakses dan mana yang harus diabaikan. Instruksi ini ditulis dalam format yang mudah dipahami, menggunakan directive seperti User-agent dan Disallow.

-

User-agent: Menentukan crawler mana yang akan dikenai instruksi.*berarti semua crawler. Anda juga bisa menargetkan crawler spesifik, sepertiGooglebot,Bingbot, atau lainnya. -

Disallow: Menentukan path atau URL yang tidak boleh diakses oleh crawler yang disebutkan diUser-agent./wp-admin/misalnya, akan mencegah akses ke area admin WordPress. -

Allow: Menentukan path atau URL yang boleh diakses, meskipun terdapat instruksiDisallowsebelumnya. Ini berguna untuk memberikan pengecualian pada aturan umum. -

Sitemap: Menginformasikan mesin pencari lokasi sitemap XML Anda, yang berisi daftar semua halaman di situs Anda.

Menyiapkan Robot.txt untuk Google Adsense di WordPress

Tujuan utama pengaturan robot.txt untuk Adsense adalah memastikan bahwa Googlebot dapat mengakses semua halaman yang relevan dengan iklan, sementara mencegah akses ke area yang tidak perlu atau sensitif. Berikut langkah-langkahnya:

-

Akses File robot.txt: Anda dapat mengakses dan mengedit file robot.txt melalui beberapa cara:

-

Melalui FTP/File Manager: Jika Anda menggunakan FTP atau file manager hosting Anda, Anda dapat mengakses file robot.txt di root direktori situs Anda. Jika file tersebut belum ada, Anda perlu membuatnya.

-

Melalui Plugin WordPress: Beberapa plugin WordPress menawarkan fitur untuk mengelola robot.txt. Plugin ini biasanya menyediakan antarmuka yang lebih user-friendly dibandingkan dengan pengeditan manual. Namun, pastikan plugin yang Anda gunakan terpercaya dan terupdate.

-

-

Menentukan User-agent: Mulailah dengan menentukan crawler yang ingin Anda targetkan. Untuk Google, gunakan

User-agent: Googlebot. Jika Anda ingin instruksi berlaku untuk semua crawler, gunakanUser-agent: *. -

Menentukan Disallow: Ini adalah bagian yang paling penting. Anda perlu menentukan path mana yang tidak boleh diakses oleh Googlebot. Beberapa path yang umum diblokir adalah:

/wp-admin/: Area admin WordPress, berisi informasi sensitif dan tidak perlu diindeks./wp-includes/: Direktori berisi file inti WordPress, tidak perlu diindeks./wp-content/cache/: Direktori cache, berisi file sementara yang tidak perlu diindeks./wp-content/uploads/: Jika Anda menyimpan file yang tidak relevan dengan konten website, misalnya backup database, sebaiknya diblokir. Namun jika anda mengupload gambar dan video untuk konten utama, sebaiknya jangan diblokir.- Path ke halaman yang tidak ingin diindeks, seperti halaman draft, halaman internal, atau halaman khusus lainnya.

-

Menentukan Allow (Opsional): Jika Anda telah memblokir suatu path tetapi ingin mengizinkan akses ke subdirektori tertentu, gunakan directive

Allow. Misalnya, jika Anda memblokir/wp-content/uploads/, tetapi ingin mengizinkan akses ke/wp-content/uploads/images/, Anda dapat menambahkanAllow: /wp-content/uploads/images/. -

Menambahkan Sitemap: Tambahkan lokasi sitemap XML Anda agar Googlebot dapat dengan mudah menemukan dan mengindeks halaman-halaman di situs Anda. Biasanya, sitemap terletak di

sitemap.xmlatausitemap_index.xml. Contoh:Sitemap: https://www.example.com/sitemap.xml

Contoh Robot.txt:

User-agent: Googlebot

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /wp-content/cache/

#Disallow: /wp-content/uploads/ (Hanya jika perlu diblokir)

Allow: /wp-content/uploads/images/ (Jika diperlukan)

Sitemap: https://www.example.com/sitemap.xmlStrategi Lanjutan

-

Penggunaan

User-agentspesifik: Anda dapat menargetkan crawler spesifik denganUser-agentyang berbeda. Misalnya, Anda dapat mengizinkan akses ke semua halaman untuk Googlebot, tetapi memblokir beberapa halaman untuk crawler lain. -

Penggunaan wildcard: Wildcard

*dapat digunakan untuk memblokir seluruh direktori atau jenis file. Misalnya,Disallow: /*.tmpakan memblokir semua file dengan ekstensi.tmp. -

Testing Robot.txt: Setelah membuat atau mengedit robot.txt, uji konfigurasi Anda menggunakan alat testing robot.txt yang tersedia secara online. Alat ini akan menunjukkan halaman mana yang diizinkan dan yang diblokir oleh robot.txt Anda.

-

Regular Update: Pastikan untuk memperbarui robot.txt Anda secara berkala, terutama jika Anda melakukan perubahan besar pada struktur situs Anda.

Pemecahan Masalah Umum

-

Halaman tidak diindeks: Jika halaman Anda tidak diindeks meskipun seharusnya diizinkan oleh robot.txt, periksa kembali konfigurasi robot.txt Anda dan pastikan tidak ada kesalahan. Periksa juga apakah ada masalah lain, seperti kesalahan server atau masalah technical SEO lainnya.

-

Halaman yang seharusnya diblokir tetap diindeks: Jika halaman yang seharusnya diblokir tetap diindeks, periksa kembali konfigurasi robot.txt Anda. Pastikan Anda telah menggunakan path yang benar dan tidak ada kesalahan dalam penulisan.

-

Penggunaan plugin yang konflik: Jika Anda menggunakan beberapa plugin WordPress yang memengaruhi robot.txt, pastikan plugin tersebut tidak saling berkonflik. Coba nonaktifkan plugin satu per satu untuk mengidentifikasi penyebab konflik.

Kesimpulan

Pengaturan robot.txt yang tepat sangat penting untuk keberhasilan situs WordPress Anda, khususnya jika Anda menggunakan Google Adsense. Dengan mengikuti langkah-langkah dan strategi yang dijelaskan dalam artikel ini, Anda dapat memastikan bahwa Googlebot dapat mengakses halaman-halaman yang relevan untuk iklan Anda, sementara mencegah akses ke area yang tidak perlu atau sensitif. Ingatlah untuk selalu menguji konfigurasi robot.txt Anda dan memperbaruinya secara berkala untuk menjaga optimasi situs Anda. Dengan pengelolaan robot.txt yang efektif, Anda dapat memaksimalkan pendapatan Adsense dan meningkatkan performa SEO situs Anda secara keseluruhan. Jangan ragu untuk berkonsultasi dengan pakar SEO jika Anda mengalami kesulitan dalam mengkonfigurasi robot.txt Anda.