google adsense robots.txt cara ijinkan

Table of Content

Google Adsense dan Robots.txt: Panduan Lengkap Mengizinkan Crawler Googlebot

Google AdSense, program periklanan kontekstual Google, merupakan sumber pendapatan yang signifikan bagi banyak pemilik situs web. Agar AdSense dapat berfungsi dengan optimal dan menampilkan iklan di situs Anda, Googlebot, crawler (robot perayap) Google, harus dapat mengakses dan mengindeks halaman-halaman situs Anda. File robots.txt memainkan peran krusial dalam mengontrol akses crawler ini. Memahami cara mengkonfigurasi robots.txt untuk mengizinkan Googlebot mengakses halaman-halaman yang menampilkan iklan AdSense sangat penting untuk memaksimalkan pendapatan Anda. Artikel ini akan membahas secara mendalam tentang interaksi antara Google AdSense, robots.txt, dan bagaimana cara mengizinkan Googlebot dengan benar.

Memahami File Robots.txt

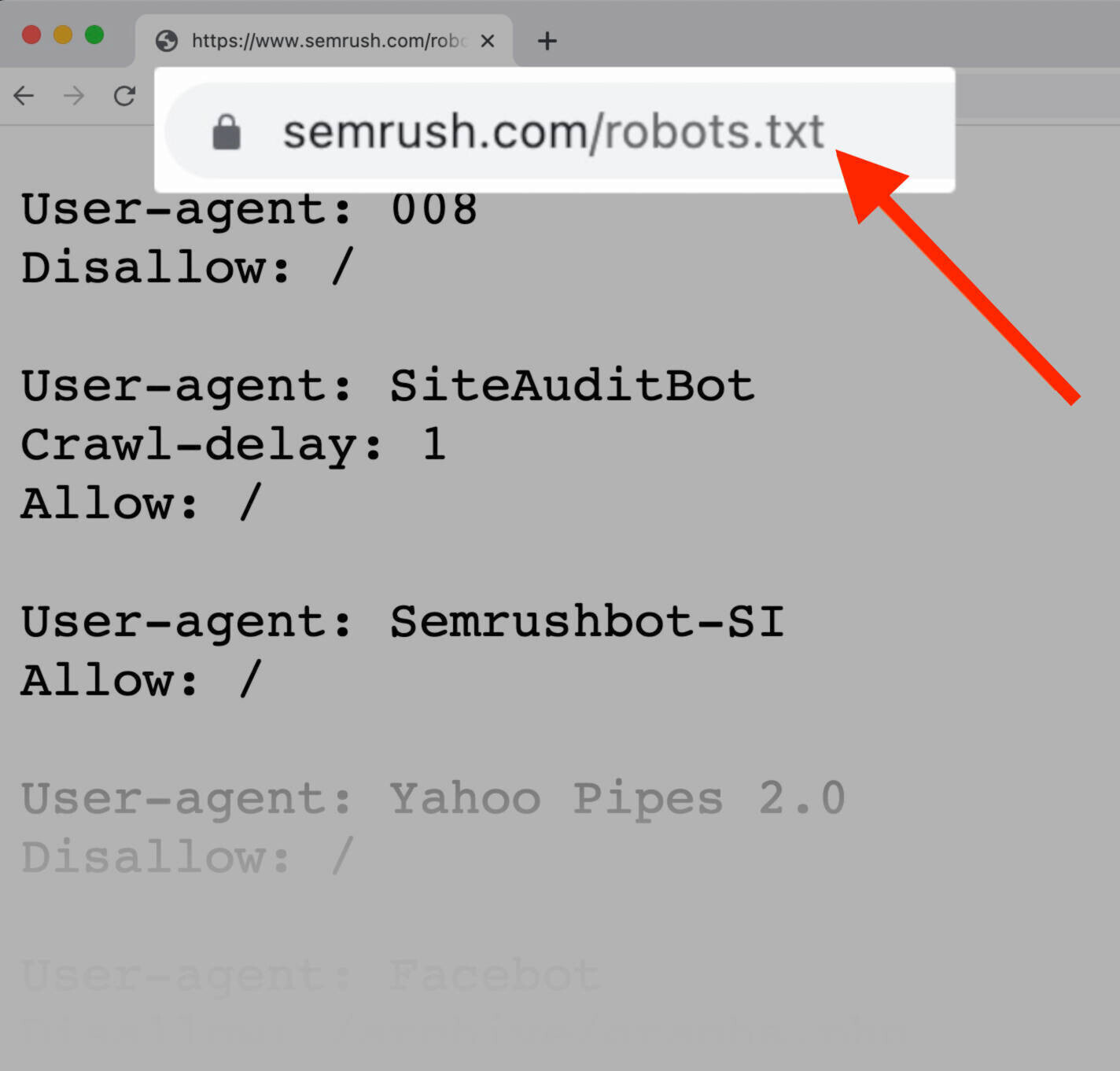

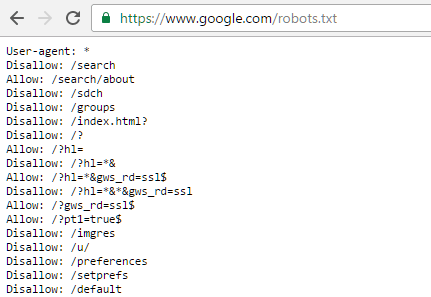

File robots.txt adalah file teks sederhana yang ditempatkan di direktori root situs web Anda. File ini memberikan instruksi kepada crawler mesin pencari, termasuk Googlebot, tentang halaman mana yang boleh diakses dan mana yang tidak boleh diakses. Ini bertindak sebagai "peta jalan" yang membantu crawler menavigasi situs web Anda secara efisien dan menghormati preferensi Anda. Dengan kata lain, robots.txt bukan alat untuk menyembunyikan konten dari pengguna, tetapi untuk memberi tahu crawler apa yang boleh dan tidak boleh mereka indeks.

Struktur File Robots.txt

File robots.txt memiliki struktur yang sederhana dan mudah dipahami. Ia terdiri dari beberapa baris instruksi, yang masing-masing dimulai dengan arahan User-agent diikuti oleh arahan Disallow atau Allow.

-

User-agent:Menentukan crawler mana yang akan dipengaruhi oleh instruksi yang diberikan.User-agent: *berarti instruksi berlaku untuk semua crawler. Anda juga dapat menentukan crawler tertentu, misalnyaUser-agent: Googlebot.

Disallow:Menentukan jalur URL yang tidak boleh diakses oleh crawler yang ditentukan. Misalnya,Disallow: /private/akan mencegah crawler mengakses semua halaman di dalam direktori/private/.-

Allow:Menentukan jalur URL yang boleh diakses oleh crawler yang ditentukan, meskipun jalur tersebut mungkin termasuk dalam arahanDisallow. Ini berguna untuk memberikan pengecualian pada aturanDisallow.

Mengapa Googlebot Membutuhkan Akses?

Googlebot membutuhkan akses ke halaman-halaman situs Anda untuk beberapa alasan penting terkait dengan AdSense:

Penempatan Iklan: Googlebot perlu merayapi halaman Anda untuk memahami kontennya dan menentukan tempat terbaik untuk menampilkan iklan AdSense. Algoritma AdSense menganalisis konten untuk mencocokkan iklan yang relevan, dan tanpa akses, pencocokan iklan akan kurang optimal.

-

Pemantauan Kinerja: Googlebot memantau kinerja iklan di situs Anda. Ini memungkinkan Google untuk melacak klik, tayangan, dan metrik lainnya yang penting untuk mengukur efektivitas kampanye periklanan Anda.

-

Pemeriksaan Kepatuhan Kebijakan: Googlebot memastikan bahwa situs Anda mematuhi kebijakan AdSense. Ini termasuk memeriksa konten yang tidak pantas, praktik penipuan, dan pelanggaran kebijakan lainnya yang dapat mengakibatkan penonaktifan akun AdSense.

-

Indeksasi Halaman: Meskipun AdSense tidak secara langsung bergantung pada peringkat pencarian, indeksasi yang baik membantu meningkatkan visibilitas situs Anda, yang pada akhirnya dapat meningkatkan lalu lintas dan pendapatan AdSense.

Mengizinkan Googlebot dalam File Robots.txt untuk AdSense

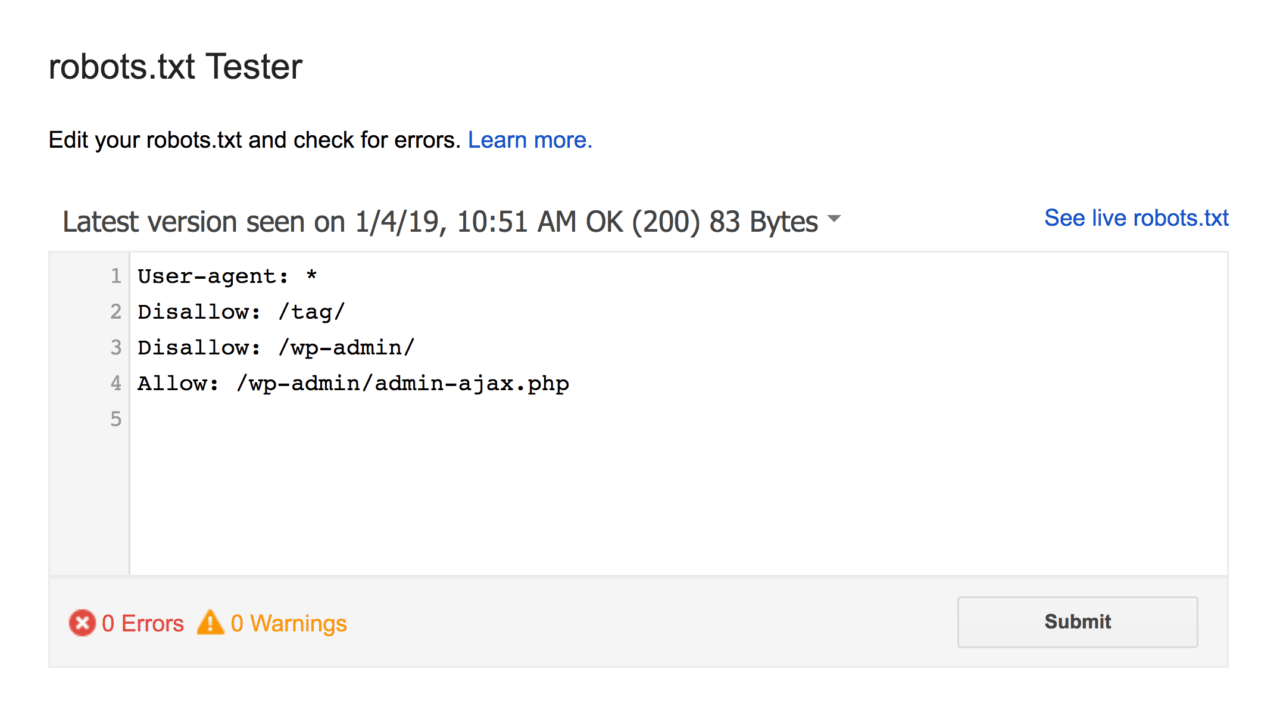

Untuk memastikan Googlebot dapat mengakses semua halaman yang menampilkan iklan AdSense, Anda perlu memastikan bahwa file robots.txt Anda tidak memblokir akses ke halaman-halaman tersebut. Cara paling sederhana adalah dengan tidak memasukkan arahan Disallow sama sekali, atau hanya membatasi akses ke direktori atau file yang benar-benar perlu disembunyikan.

Contoh file robots.txt yang mengizinkan Googlebot mengakses seluruh situs:

User-agent: *

Allow: /Contoh file robots.txt yang mengizinkan Googlebot mengakses seluruh situs kecuali direktori /private/:

User-agent: *

Allow: /

Disallow: /private/Kesalahan Umum dan Cara Mengatasinya

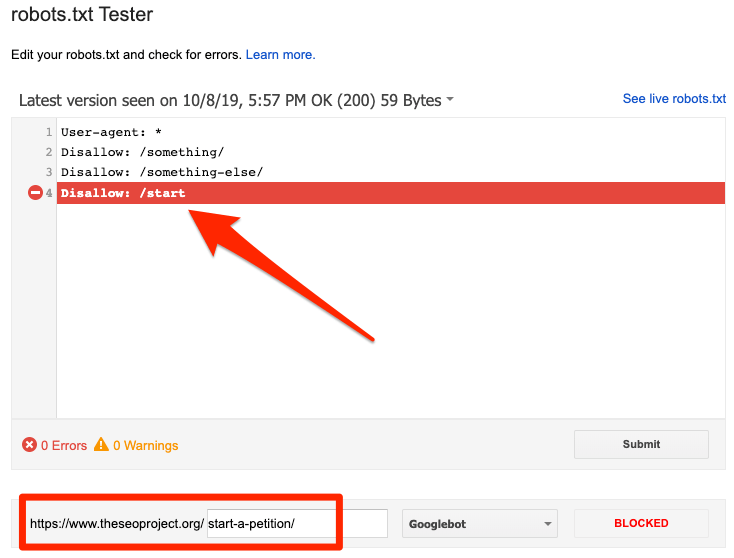

Berikut beberapa kesalahan umum yang dapat mencegah Googlebot mengakses halaman Anda dan berdampak negatif pada pendapatan AdSense:

-

Blokir yang Tidak Disengaja: Pastikan Anda tidak secara tidak sengaja memblokir direktori atau file yang berisi kode iklan AdSense dalam file

robots.txtAnda. Tinjau filerobots.txtAnda secara berkala untuk memastikan tidak ada blok yang tidak perlu. -

Penggunaan

Disallowyang Berlebihan: Hindari penggunaanDisallowyang berlebihan. Hanya blokir halaman atau direktori yang benar-benar perlu disembunyikan dari mesin pencari. Blok yang berlebihan dapat menghambat perayapan Googlebot dan memengaruhi kinerja AdSense. -

Kesalahan dalam Sintaks: Pastikan sintaks file

robots.txtAnda benar. Kesalahan sintaks dapat menyebabkan file tersebut tidak diproses dengan benar, sehingga Googlebot mungkin tidak dapat mengikuti instruksi yang diberikan. -

Tidak Meng-update Robots.txt: Jika Anda membuat perubahan pada struktur situs web Anda, pastikan untuk memperbarui file

robots.txtAnda agar mencerminkan perubahan tersebut. Kegagalan untuk melakukan ini dapat menyebabkan Googlebot mengabaikan bagian-bagian situs Anda yang baru. -

Mengabaikan Sitemap: Meskipun

robots.txtpenting, jangan lupa untuk menyertakan sitemap XML Anda. Sitemap membantu Googlebot menemukan dan mengindeks halaman-halaman penting di situs Anda, termasuk halaman-halaman yang menampilkan iklan AdSense. Sertakan URL sitemap Anda dalam filerobots.txtuntuk memudahkan Googlebot menemukannya.

Kesimpulan

File robots.txt merupakan alat yang penting untuk mengontrol akses crawler mesin pencari ke situs web Anda. Namun, penting untuk memahami bahwa ia bukan alat untuk menyembunyikan konten dari pengguna. Untuk memaksimalkan pendapatan AdSense, pastikan file robots.txt Anda dikonfigurasi dengan benar untuk mengizinkan Googlebot mengakses semua halaman yang relevan. Tinjau dan perbarui file robots.txt Anda secara berkala untuk memastikan bahwa ia mencerminkan struktur situs web Anda dan tidak memblokir akses Googlebot secara tidak sengaja. Dengan memahami dan menerapkan strategi yang benar dalam mengelola file robots.txt, Anda dapat memastikan bahwa Googlebot dapat merayapi situs web Anda secara efektif, sehingga memaksimalkan pendapatan AdSense Anda. Jangan ragu untuk menggunakan alat penguji robots.txt yang tersedia secara online untuk memverifikasi konfigurasi file Anda dan memastikan tidak ada kesalahan. Dengan pendekatan yang hati-hati dan teliti, Anda dapat memastikan bahwa situs web Anda dioptimalkan untuk menghasilkan pendapatan maksimum dari Google AdSense.