pasang adsense dengan robot txt

Table of Content

Pasang Adsense dengan Robot.txt: Panduan Lengkap dan Strategi Optimasi

Google AdSense merupakan program periklanan yang banyak digunakan oleh pemilik website untuk menghasilkan pendapatan. Namun, agar AdSense dapat berfungsi optimal dan mematuhi kebijakan Google, pemahaman yang baik tentang robots.txt sangatlah krusial. File robots.txt adalah file teks sederhana yang memberi instruksi kepada crawler (robot perayap) mesin pencari, termasuk Googlebot, tentang halaman mana yang boleh dan tidak boleh diakses. Penggunaan robots.txt yang tepat dapat membantu mencegah masalah pengindeksan yang tidak diinginkan dan memastikan AdSense berjalan lancar. Artikel ini akan membahas secara detail tentang bagaimana memasang AdSense dengan mempertimbangkan robots.txt, termasuk strategi optimasi untuk memaksimalkan pendapatan dan menghindari pelanggaran kebijakan.

Memahami Peran robots.txt dalam Konteks AdSense

Sebelum membahas implementasinya, penting untuk memahami peran robots.txt dalam konteks AdSense. File ini tidak secara langsung mengontrol tampilan iklan AdSense. Iklan AdSense ditampilkan berdasarkan kode iklan yang tertanam di halaman web, bukan berdasarkan instruksi di robots.txt. Namun, robots.txt berperan penting dalam:

-

Pengoptimalan SEO: Dengan memblokir halaman yang tidak relevan atau berkualitas rendah dari mesin pencari, Anda dapat meningkatkan kualitas situs web Anda di mata Google. Sebuah situs web yang terstruktur dengan baik dan berisi konten berkualitas tinggi lebih cenderung diterima dan disetujui oleh program AdSense.

-

Mencegah Penyalahgunaan:

robots.txtdapat digunakan untuk memblokir akses bot dan crawler yang mencurigakan yang dapat mencoba untuk mengeksploitasi AdSense atau melakukan aktivitas berbahaya lainnya. -

Pengelolaan Crawling: Dengan mengontrol halaman mana yang diakses oleh crawler, Anda dapat mengoptimalkan penggunaan bandwidth server dan mengurangi beban server. Hal ini penting terutama untuk situs web dengan lalu lintas tinggi.

-

Perlindungan Konten: Anda dapat menggunakan

robots.txtuntuk melindungi halaman tertentu yang mungkin tidak ingin Anda indeks oleh mesin pencari, misalnya halaman internal yang bersifat sensitif atau halaman yang masih dalam tahap pengembangan.

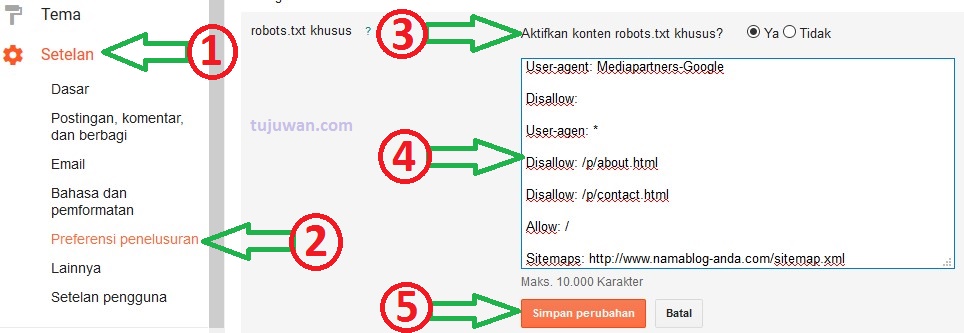

Cara Menambahkan robots.txt ke Situs Web Anda

File robots.txt harus ditempatkan di direktori root situs web Anda. Artinya, URL-nya adalah www.namadomainanda.com/robots.txt atau namadomainanda.com/robots.txt (tanpa www). Anda dapat membuat file ini menggunakan editor teks sederhana seperti Notepad (Windows) atau TextEdit (Mac). Setelah selesai, simpan file tersebut dengan ekstensi .txt.

Contoh robots.txt untuk Situs Web dengan AdSense:

Berikut adalah contoh sederhana dari file robots.txt:

User-agent: *

Allow: /

Disallow: /private/

Disallow: /admin/Penjelasan:

User-agent: *: Ini menargetkan semua crawler (robot perayap), termasuk Googlebot.Allow: /: Ini mengizinkan akses ke semua halaman di situs web Anda.Disallow: /private/: Ini memblokir akses ke direktori/private/. Anda dapat mengganti/private/dengan direktori lain yang berisi informasi sensitif atau halaman yang tidak ingin Anda indeks.Disallow: /admin/: Ini memblokir akses ke direktori/admin/, yang biasanya berisi panel administrasi situs web Anda.

Strategi Optimasi robots.txt untuk AdSense

Berikut beberapa strategi untuk mengoptimalkan robots.txt agar selaras dengan program AdSense:

-

Blokir Halaman yang Tidak Relevan: Blokir halaman yang tidak relevan dengan konten utama situs web Anda, seperti halaman kesalahan 404, halaman kosong, atau halaman yang berisi konten duplikat. Hal ini akan membantu meningkatkan kualitas situs web Anda dan meningkatkan peluang penerimaan AdSense.

-

Blokir Halaman yang Mengandung Konten yang Tidak Sesuai dengan Kebijakan AdSense: Pastikan Anda memblokir halaman yang berisi konten yang melanggar kebijakan AdSense, seperti konten dewasa, konten yang mempromosikan kekerasan, atau konten yang melanggar hak cipta.

-

Blokir Halaman yang Belum Siap: Jika Anda memiliki halaman yang masih dalam tahap pengembangan, blokir akses ke halaman tersebut hingga siap untuk dipublikasikan. Ini akan mencegah mesin pencari mengindeks konten yang belum selesai atau tidak optimal.

-

Gunakan Sitemap XML: Meskipun

robots.txtmemberi instruksi kepada crawler tentang halaman mana yang boleh diakses, sitemap XML memberi tahu mesin pencari tentang struktur situs web Anda dan halaman mana yang paling penting. Dengan mengirimkan sitemap XML ke Google Search Console, Anda dapat memastikan bahwa halaman-halaman penting Anda diindeks dengan benar. -

Pantau Kinerja

robots.txt: Gunakan Google Search Console untuk memantau kinerjarobots.txtAnda. Periksa apakah ada kesalahan atau masalah dalam filerobots.txtAnda dan perbaiki jika diperlukan. -

Periksa Secara Berkala: Pastikan untuk memeriksa dan memperbarui file

robots.txtAnda secara berkala. Kebutuhan Anda mungkin berubah seiring waktu, dan pembaruan ini akan memastikan bahwa filerobots.txtAnda selalu mencerminkan struktur dan konten situs web Anda yang terbaru. -

Jangan Memblokir Halaman yang Mengandung Iklan AdSense: Jangan secara tidak sengaja memblokir halaman yang berisi kode iklan AdSense Anda. Ini akan mencegah iklan ditampilkan dan mengurangi potensi pendapatan Anda.

Kesalahan Umum dalam Penggunaan robots.txt

Beberapa kesalahan umum yang perlu dihindari:

-

Memblokir halaman yang penting: Jangan memblokir halaman yang berisi konten berkualitas tinggi dan relevan dengan niche situs web Anda, termasuk halaman yang menampilkan iklan AdSense.

-

Menggunakan sintaks yang salah: Pastikan Anda menggunakan sintaks yang benar dalam file

robots.txt. Kesalahan sintaks dapat menyebabkan masalah dalam pengindeksan dan pengaksesan halaman situs web Anda. -

Tidak memperbarui

robots.txt:robots.txtharus diperbarui secara berkala untuk mencerminkan perubahan dalam struktur dan konten situs web Anda. -

Mengandalkan

robots.txtuntuk keamanan:robots.txtbukanlah solusi keamanan yang handal. Jangan mengandalkannya untuk melindungi informasi sensitif. Gunakan langkah-langkah keamanan yang lebih kuat, seperti otentikasi dan enkripsi.

Kesimpulan

robots.txt adalah alat yang ampuh untuk mengelola akses crawler ke situs web Anda. Dengan menggunakan robots.txt secara efektif, Anda dapat meningkatkan kualitas situs web Anda, mengoptimalkan pengindeksan mesin pencari, dan memastikan bahwa program AdSense Anda berjalan dengan lancar dan sesuai dengan kebijakan Google. Ingatlah untuk selalu memeriksa dan memperbarui file robots.txt Anda secara berkala dan selalu mengutamakan kualitas konten dan kepatuhan terhadap kebijakan AdSense. Dengan pendekatan yang tepat, Anda dapat memanfaatkan robots.txt untuk meningkatkan pendapatan dan keberhasilan program AdSense Anda.